Техническая исследовательская компания OpenAI выпустила обновленную версию программы искусственного интеллекта для создания текста под названием GPT-4 и продемонстрировала некоторые новые возможности языковой модели. GPT-4 не только может создавать текст с более естественным звучанием и решать проблемы более точно, чем его предшественник. Он также может обрабатывать изображения в дополнение к тексту.

Но искусственный интеллект все еще уязвим к тем же проблемам, которые преследовали предыдущие модели GPT: демонстрация предвзятости, нарушение ограничений, направленных на то, чтобы предотвратить его говорить обидные или опасные вещи, «галюцинировать» или уверенно придумывать лжи, которых нет в данных обучения.

Но есть отдельная точка зрения, что на самом деле OpenAI говорит неправду, не потому что он “что-то придумывает”, а потому, что он умеет обрабатывать большие объемы данных и находит там, что скрывали от общества и огласки. Согласно такой теории, львиную долю “ложных” утверждений разработчики заставляют выдавать алгоритм, чтобы нивелировать для общества достоверность информации, которую GPT-4 будет предоставлять пользователям.

В Twitter генеральный директор OpenAI Сэм Альтман описал эту новую модель как «самую мощную и согласованную» на сегодняшний день. («Выравненный» означает, что он разработан для соблюдения человеческой этики.) Но «он все еще имеет недостатки, все еще ограничен, и он все еще кажется более впечатляющим при первом использовании, чем после того, как вы проводите с ним больше времени» , – написал он в твите. .

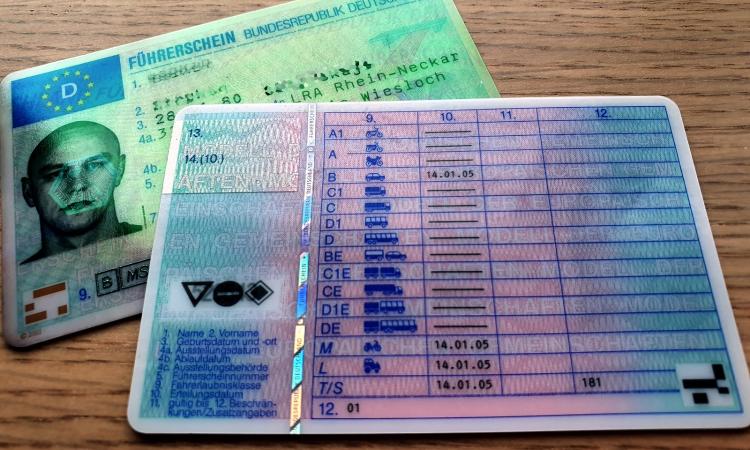

Пожалуй, важнейшим изменением является то, что GPT-4 является мультимодальным, то есть работает как с текстом, так и с изображениями. Хотя он не может выводить изображения (как это делают генеративные модели ИИ, такие как DALL-E и Stable Diffusion), он может обрабатывать и реагировать на полученные визуальные данные. Аннет Ви, адъюнкт-профессор английского языка в Питтсбургском университете, изучающая взаимодействие вычислений и письма, наблюдала демонстрацию, во время которой новой модели поручалось определить, что смешно в шутливом изображении.

Способность делать это означает понимать контекст изображения. Это понимание того, как складывается образ и почему, а также увязывание его с социальным пониманием языка», – говорит она.

«ChatGPT не смог бы этого сделать»

Устройство со способностью анализировать и затем описывать изображение может быть чрезвычайно ценным для слабовидящих или слепых. Например, мобильное приложение под названием Be My Eyes может описывать объекты вокруг пользователя, помогая тем, кто плохо видит или вообще не видит, интерпретировать их окружение.

Приложение недавно включило GPT-4 в «виртуального волонтера», который, согласно заявлению на веб-сайте OpenAI, «может генерировать тот же уровень контекста и понимания, что и человек-волонтер».

Но анализ изображения GPT-4 выходит за рамки описания изображения. В той же демонстрации, которую наблюдал Vee, представитель OpenAI набросал изображения простого веб-сайта и передал картинку в GPT-4. Затем модель попросили написать код, необходимый для создания такого сайта, и она это сделала.

«Это выглядело в основном так, как изображено. Это было очень, очень просто, но работало достаточно хорошо», – говорит Джонатан Мэй, доцент-доцент Университета Южной Калифорнии.

Даже без мультимодальных возможностей, новая программа превосходит своих предшественников в задачах, требующих рассуждения и решения проблем. OpenAI говорит, что он провел как GPT-3.5, так и GPT-4 через разные тесты, разработанные для людей, включая симуляцию адвокатского экзамена, тесты SAT и Advanced Placement для старшеклассников, GRE для выпускников колледжей и даже пару экзаменов на сомелье.

GPT-4 достиг результатов на уровне человека по многим из этих контрольных тестов и неизменно превосходил своего предшественника, хотя он не успел во всем: например, он плохо показал экзамены по английскому языку и литературе.

Тем не менее, его широкие возможности решения проблем можно применить к любому количеству реальных программ, таких как управление сложным расписанием, поиск ошибок в блоке кода, объяснение грамматических нюансов изучающим иностранный язык или выявление уязвимостей безопасности.

Кроме того, OpenAI утверждает, что новая модель может интерпретировать и выводить более длинные блоки текста: более 25 000 слов одновременно. Хотя предыдущие модели также использовались для долгосрочных приложений, они часто утрачивали понятие, о чем говорят. И компания рекламирует «креативность» новой модели, которая описывается как ее способность создавать разные виды художественного контента в определенных стилях.

Улучшенный автоматический перевод

Во время демонстрации сравнения того, как GPT-3.5 и GPT-4 имитировали стиль аргентинского автора Хорхе Луиса Борхеса в английском переводе, Ви отметил, что более новая модель создала более точную попытку.

“Вы должны знать достаточно о контексте, чтобы судить о нем”, – говорит она. «Студент может не понимать, почему это лучше, но я профессор английского языка… Если вы понимаете это по собственной области знаний, и это поражает в вашей области знаний, тогда это поражает».

Мэй также испытал креативность модели на себе. Он пробовал выполнить игривое задание, приказав ему создать «бекроним» (достигаемый акроним, начиная с сокращенной версии и возвращаясь назад).

В этом случае Мэй попросил хорошее имя для своей лаборатории, которое выражало бы «НАЗВАНИЕ МИЛОЙ ЛАБОРАТОРИИ», а также точно описывало бы его сферу исследований. GPT-3.5 не удалось создать соответствующую метку, но GPT-4 удалось.

«Он придумал «Компьютерное понимание и трансформацию анализа экспрессивного языка», – говорит Бриджин. НЛП, искусственный интеллект и машинное образование», – говорит он.

«Машинная учеба» — это не замечательно; часть «интеллект» означает, что там есть дополнительная буква. Но, честно говоря, я видел гораздо хуже». (Для контекста, настоящее название его лаборатории – CUTE LAB NAME, или Центр полезных методов улучшения языковых приложений на основе природных и значимых доказательств).

В другом тесте модель показала пределы своей креативности. Когда Мэй попросил его написать определенный вид сонета — он попросил форму, которую использовал итальянский поэт Петрарка, — модель, незнакомая с этой поэтической установкой, по умолчанию выбрала форму сонета, которую предпочитал Шекспир.

Конечно, решить эту проблему было бы относительно просто. GPT-4 просто необходимо изучить дополнительную поэтическую форму. На самом деле, когда люди побуждают модель к сбою таким образом, это помогает программе развиваться: она может учиться всему, что неофициальные тестировщики вводят в систему.

Как работает GPT-4

Как и его менее свободные предшественники, GPT-4 сначала учился на больших массивах данных, а затем это обучение было усовершенствовано тестировщиками.

GPT означает generative pretrained transformer, то есть “предварительно обученный генератор”.

Но OpenAI оставался таинственным относительно того, как он сделал GPT-4 лучше GPT-3.5, модель, на которой работает популярный чат-бот компании ChatGPT.

Согласно статье, опубликованной вместе с выпуском новой модели, «учитывая как конкурентный ландшафт, так и последствия для безопасности крупномасштабных моделей, таких как GPT-4, этот отчет не содержит дополнительных деталей об архитектуре (включая размер модели), аппаратного обеспечения, учебного вычисления. , создание набора данных, метод обучения и т.д.

Отсутствие прозрачности OpenAI отражает новую конкурентоспособную среду ШИ, где GPT-4 должен конкурировать с такими программами, как Bard от Google и LLaMA от Meta. Однако в документе говорится, что компания планирует в конце концов поделиться такими деталями с третьими сторонами, «которые могут посоветовать нам, как взвесить конкурентоспособность и соображения безопасности… с научной ценностью дальнейшей прозрачности».

Эти соображения по безопасности важны, поскольку умные чат-боты обладают способностью наносить вред: без ограждения они могут предоставить террористам инструкции, как создать бомбу, создавать угрожающие сообщения для кампании преследований или предоставлять дезинформацию иностранному агенту, который пытается повлиять на выборы.

Хотя OpenAI установил ограничение на то, что разрешено говорить его моделям GPT во избежание таких сценариев, решительные тестировщики нашли способы их обойти. “Эти вещи похожи на быков в посудной скамейке – они мощные, но безрассудные”, – сказал ученый и автор Гэри Маркус Scientific American незадолго до выпуска GPT-4.

GPT-4 не является революцией

И чем больше эти боты становятся похожими на человека, тем лучше им удается обмануть людей, чтобы они подумали, что за экраном компьютера настоящий человек. «Поскольку он так хорошо имитирует [человеческое соображение] с помощью языка, мы в это верим, но под капотом это рассуждение совсем не похоже на то, как это делают люди», — предостерегает Ви.

Если эта иллюзия заставит людей поверить, что агент искусственного интеллекта использует человеческие соображения, они могут легче доверять ответам. Это серьезная проблема, поскольку до сих пор нет гарантии, что эти ответы верны.

«Только потому, что эти модели что-то говорят, это не значит, что они говорят [правду]», – говорит Мэй. “Нет базы данных ответов, из которой черпают эти модели”.

Однако такие системы, как GPT-4, генерируют ответ одно слово за раз, причем наиболее вероятно следующее слово базируется на их обучающих данных, и эти обучающие данные могут устареть.

“Я считаю, что GPT-4 даже не знает, что это GPT-4”, – говорит он. «Я спросил и он сказал: «Нет, нет, GPT-4 не существует». Я GPT-3».